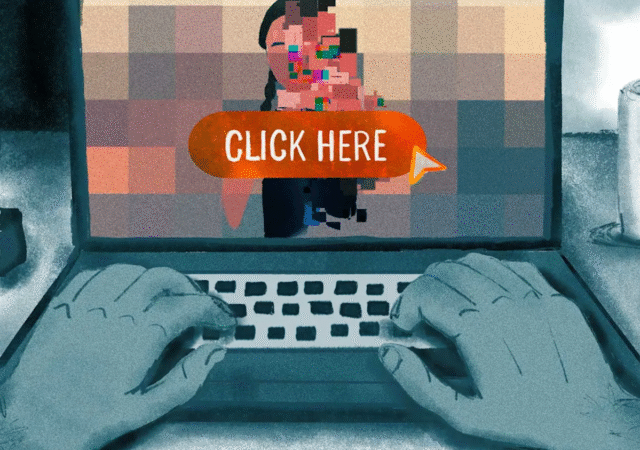

A New York Times jelentése szerint az AI által generált gyermekek szexuális zaklatása (CSAM) elárasztotta az internetet. Az olyan szervezetek kutatói, mint az Internet Watch Foundation és az eltűnt és kizsákmányolt gyermekek Nemzeti Központja, figyelmeztetik, hogy ez az új AI-által létrehozott CSAM szinte megkülönböztethetetlen az igazi dologtól.

Menjünk át néhány számot. Az Internet Watch Foundation, a nonprofit szervezet, amely a CSAM jelentéseit vizsgálja és gyűjti, idén 1 286 AI által generált videót azonosított. Ezt összehasonlítják mindössze két videóval, amelyet 2024 első felében azonosítottak. Ez exponenciális növekedés.

🔎 A mesterséges intelligencia (AI) fejleményei számos előnyt jelentenek, ideértve a tanulás és az innováció támogatását is. Ugyanakkor egyre növekvő aggodalomra ad okot, hogy az AI hogyan lehet visszaélni a gyermekek szexuális zaklatásának (CSAM) létrehozásában és megosztásában, amelyet AI-CSAM-nek neveznek.

… Pic.twitter.com/lgfrqnbk8n

– Az Internet Watch Foundation (IWF) (@iwfhotline) 2025. július 8 -án

Az eltűnt és kizsákmányolt gyermekek Nemzeti Központja újból megerősíti ezeket a statisztikákat. Azt mondta a NYT-nek, hogy 2025 első felében 485 000 jelentést kapott az AI által generált CSAM-ról, beleértve a állóképeket és videókat.

“Ez egy kanári a szénbányában”-mondta Derek Ray-Hill, az Internet Watch Foundation ideiglenes vezérigazgatója. “Van egy abszolút szökőár, amit látunk.”

Ez a technológia folyamatosan javul, így a videók és a képek reálisabbá váltak. Az Internet Watch Foundation olyan internetes fórumot talált, amelyben a felhasználók dicsérték, mennyire realisztikusak voltak az új videók. A jelentéstétel azt sugallja, hogy ezt a tartalmat a Sötét Web -en terjesztik, ami megnehezíti a bűnüldöző szervek számára az elkövetők azonosítását.

Érdemes emlékezni arra, hogy az AI képgenerátorok hogyan működnek. Valódi képek és videók felhasználásával képzik őket. A New York Times azt mondja, hogy az AI által generált tartalom ezen új glutjának nagy része olyan valós CSAM-ot tartalmaz, amelyet az algoritmus újból megismételt. Néhány anyag még valódi fényképeket is használ az iskolai webhelyekről és a közösségi médiáról lekaparott gyermekekről.

A kérdés e technológia korai napjaiban nyúlik vissza. 2023 -ban a Stanford Internet Obszervatórium kutatói több száz példát találtak a CSAM -ra egy adatkészletben, amelyet a képgenerátor stabil diffúziójának korai változatában használtak. A stabilitás AI szerint biztosítékokat vezetett be a biztonsági előírások javítása érdekében, és “mélyen elkötelezett amellett, hogy megakadályozza technológiánk visszaélését, különös tekintettel a káros tartalom, beleértve a CSAM teremtését és terjesztését”.

Ez arra késztette más vállalatokat, hogy elkezdjék beszámolni az AI által generált CSAM-ot az eltűnt és kizsákmányolt gyermekek Nemzeti Központjához. Az Amazon az év első felében egy óriási 380 000 AI-generált CSAM-ot jelentett, mindezt pedig lecsökkent. Az Openai 75 000 esetet jelentett.

Az NCMEC üdvözli a kaliforniai állam jogalkotóját az 1831 -es AB átadásáért, és várakozással tekint a törvénybe történő aláírásra.

Az NCMEC támogatja az AB 1831 -et, mivel a Kaliforniában a Generative AI CSAM gyermek áldozatainak jogi jogorvoslati lehetőségeivel foglalkozik. Szívesen látjuk, hogy az államok mozognak… pic.twitter.com/qzt1mgd7eo

– Az eltűnt és kizsákmányolt gyermekek nemzeti központja (@NCMEC) 2024. szeptember 4 -én

A bíróságok lassan felzárkóztak ehhez a technológiához. A DOJ tavaly ismert volt az első ismert letartóztatása, amelyben gyanúsították, hogy az AI által generált CSAM birtoklásában és elosztásáról gyanúsítottak. Egy brit ember nemrégiben 18 hónapos börtönbüntetést kapott az AI használatáért az eladott rossz képek előállításához.

„Az Igazságügyi Minisztérium az AI által generált CSAM minden formáját komoly és kialakuló fenyegetésnek tekinti”-mondta Matt Galeotti, az Igazságügyi Minisztérium Bűnügyi Osztályának vezetője a NYT-nek.

Érdemes megjegyezni, hogy az események riasztó emelkedése ellenére az AI által generált tartalom továbbra is pusztán a hatóságok és az őrző szervezetek által azonosított CSAM puszta töredékét jelenti. Például az Internet Watch Foundation 291 273 jelentést tett a CSAM-ról 2024-ben, és amint azt korábban megjegyeztük, csak két példányt generáltak.